Vue lecture

Rudra is a new keyboard-driven launcher for GNOME Shell

The world isn’t short on keyboard-based Linux launchers. Albert, Ulauncher, rofi and GNOME Do (if you’re old enough to remember that one) are among those I’ve written about in the past. Rudra is a new spin on this old staple – albeit without the extensibility dedicated quick launchers provide. What’s different here is that it’s implemented as a GNOME Shell extension, not a standalone app. The developer of Rudra, Nark Agni, describes it as a “lightning-fast, keyboard-centric launcher […] designed for power users”. Though inspired by Mac apps like Alfred and Raycast, it is far less capable than those. To […]

The world isn’t short on keyboard-based Linux launchers. Albert, Ulauncher, rofi and GNOME Do (if you’re old enough to remember that one) are among those I’ve written about in the past. Rudra is a new spin on this old staple – albeit without the extensibility dedicated quick launchers provide. What’s different here is that it’s implemented as a GNOME Shell extension, not a standalone app. The developer of Rudra, Nark Agni, describes it as a “lightning-fast, keyboard-centric launcher […] designed for power users”. Though inspired by Mac apps like Alfred and Raycast, it is far less capable than those. To […]

You're reading Rudra is a new keyboard-driven launcher for GNOME Shell, a blog post from OMG! Ubuntu. Do not reproduce elsewhere without permission.

Drgn v0.1 Released For Very Versatile Programmable Debugger

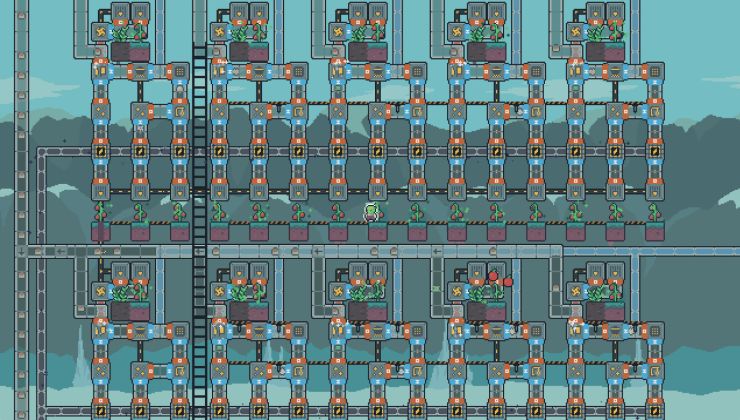

Turn recipes into huge cooking production lines in the new Snacktorio demo

Read the full article on GamingOnLinux.

Linux 7.0 Shows Significant PostgreSQL Performance Gains On AMD EPYC

Argent 1.5.3-rc6

The Wolf Among Us, The Last Express and more join the GOG Preservation Program

Read the full article on GamingOnLinux.

GNOME 50 Lands Updated Wayland Color Management v2 Support

Linux Begins Seeing Early Preparations For PCIe 7.0

MOUSE: P.I. For Hire looks awesome in the new boss trailer

Read the full article on GamingOnLinux.

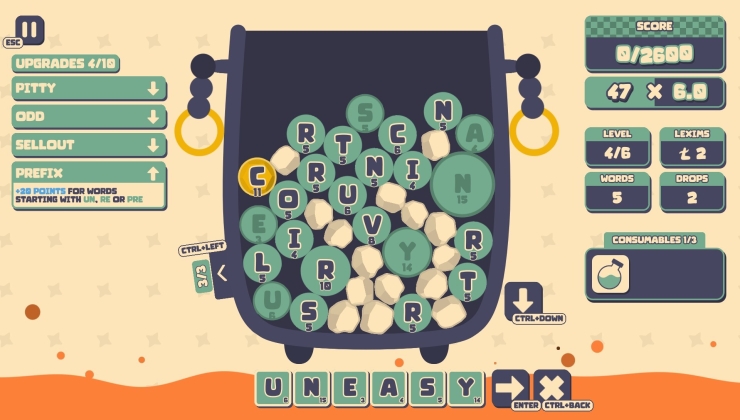

Lexispell is a Balatro-styled roguelike word game with a demo worth trying

Read the full article on GamingOnLinux.

Moomintroll: Winter's Warmth arrives April 27, will run "great" on Steam Deck

Read the full article on GamingOnLinux.

Linux 7.0 Brings Apple Type-C PHY, Snapdragon X2 & Rockchip HDMI 2.1 FRL Additions

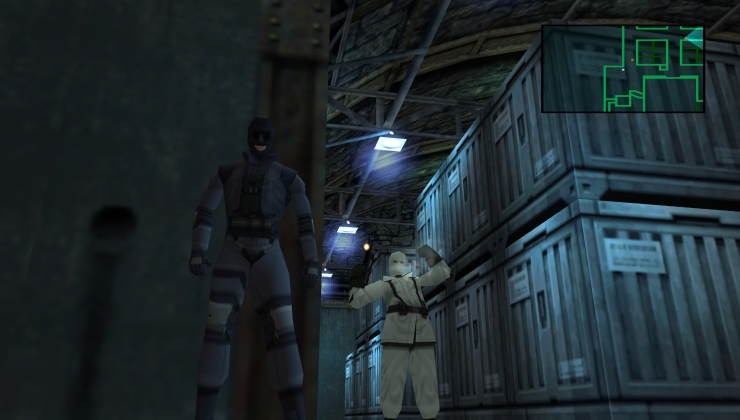

It's now easier to install MGSHDFix for Metal Gear games on Linux / Steam Deck

Read the full article on GamingOnLinux.

Steam Deck now out of stock in the EU in addition to USA, Canada and Japan

Read the full article on GamingOnLinux.

Ubuntu 26.04 Begins Its Feature Freeze

Cloud Hypervisor 51 Brings Performance Improvements, Better QCOW2 v3 Support

Mesa KosmicKrisp Driver Is Coming To iOS, More Performance & Vulkan 1.4 Expected

USB Driver For Google Tensor SoCs, UCSI Thunderbolt Alt Mode In Linux 7.0

Slay the Spire 2 arrives March 5 with 4-player co-op

Read the full article on GamingOnLinux.

Widelands, the open source Settlers-like, devs plan to ban all AI generated contributions

Read the full article on GamingOnLinux.

Steam Deck now out of stock in Europe in addition to USA, Canada and Asia

Read the full article on GamingOnLinux.

Fluff 2026.02.18

BleachBit 5.1.0 Beta adds cookie manager and expert mode

BleachBit 5.1.0 beta is out with a new cookie manager, expert mode to prevent accidental data loss, new browser support, and fixes for Linux users.

BleachBit 5.1.0 beta is out with a new cookie manager, expert mode to prevent accidental data loss, new browser support, and fixes for Linux users.

You're reading BleachBit 5.1.0 Beta adds cookie manager and expert mode, a blog post from OMG! Ubuntu. Do not reproduce elsewhere without permission.