IA : la France est bel et bien au rendez-vous

L’écosystème français des startups d’IA est en pleine ébullition, et ça promet !

Rejoignez-nous de 17 à 19h, un mercredi sur deux, pour l’émission UNLOCK produite par Frandroid et Numerama ! Actus tech, interviews, astuces et analyses… On se retrouve en direct sur Twitch ou en rediffusion sur YouTube !

Si vous voulez recevoir les meilleures actus Frandroid sur WhatsApp, rejoignez cette discussion.

Des invités passionnants et des sujets palpitants ! Notre émission UNLOCK est à retrouver un mercredi sur deux en direct, de 17 à 19h sur Twitch. Pensez aussi aux rediffusions sur YouTube !

Pour ne rater aucun bon plan, rejoignez notre nouveau channel WhatsApp Frandroid Bons Plans, garanti sans spam !

Si vous voulez recevoir les meilleures actus Frandroid sur WhatsApp, rejoignez cette discussion.

Téléchargez notre application Android et iOS ! Vous pourrez y lire nos articles, dossiers, et regarder nos dernières vidéos YouTube.

Le plus juste (ou pas) des tueurs en série revient sur nos écrans, pour un énième spin-off, cette fois centré sur sa jeunesse. Date de sortie en France, bande-annonce, casting, intrigue... Voici tout ce que l'on sait sur Dexter: Original Sin (ou Les Origines en VF).

Nous en savons désormais un peu plus pour le Nintendo Direct du 2 avril qui sera consacré à la Switch 2. Nintendo avait déjà communiqué la date. Aujourd’hui, le groupe dévoile l’heure : ce sera à partir de 15 heures (heure française). Dans un message sur les réseaux …

Aimez KultureGeek sur Facebook, et suivez-nous sur Twitter

N'oubliez pas de télécharger notre Application gratuite iAddict pour iPhone et iPad (lien App Store)

L’article Switch 2 : le Nintendo Direct a maintenant une heure en plus de la date est apparu en premier sur KultureGeek.

Disney a révélé une dynamique contrastée pour son service de streaming. Bien que Disney+ ait perdu 700 000 abonnés à l’échelle mondiale, la société reste optimiste concernant sa trajectoire financière et stratégique. Un léger revers pour Disney+, qui a clôturé l’année 2024 avec un total de 124,6 millions …

Aimez KultureGeek sur Facebook, et suivez-nous sur Twitter

N'oubliez pas de télécharger notre Application gratuite iAddict pour iPhone et iPad (lien App Store)

L’article Disney+ a perdu 700 000 abonnés, mais n’est pas inquiet pour autant est apparu en premier sur KultureGeek.

Jusqu’ici, la marotte de Mark Zuckerberg n’a pas rencontré un grand succès : en dépit des investissements, le métavers de Meta est loin d’avoir répondu aux ambitions du milliardaire (qui, pour mémoire, a rebaptisé Facebook — l’entreprise, pas le réseau social — en Meta en octobre 2021). Trois ans et demi plus tard, les équipes du Reality Labs (la branche de Meta consacrée à la réalité virtuelle et à la réalité augmentée ; auparavant nommée Oculus VR) seraient à la croisée des chemins... [Tout lire]

Jusqu’ici, la marotte de Mark Zuckerberg n’a pas rencontré un grand succès : en dépit des investissements, le métavers de Meta est loin d’avoir répondu aux ambitions du milliardaire (qui, pour mémoire, a rebaptisé Facebook — l’entreprise, pas le réseau social — en Meta en octobre 2021). Trois ans et demi plus tard, les équipes du Reality Labs (la branche de Meta consacrée à la réalité virtuelle et à la réalité augmentée ; auparavant nommée Oculus VR) seraient à la croisée des chemins... [Tout lire]

Vous cherchez un SSD, des écouteurs sans fil pour le sport ou encore une petite station électrique abordable ? Suivez le guide.

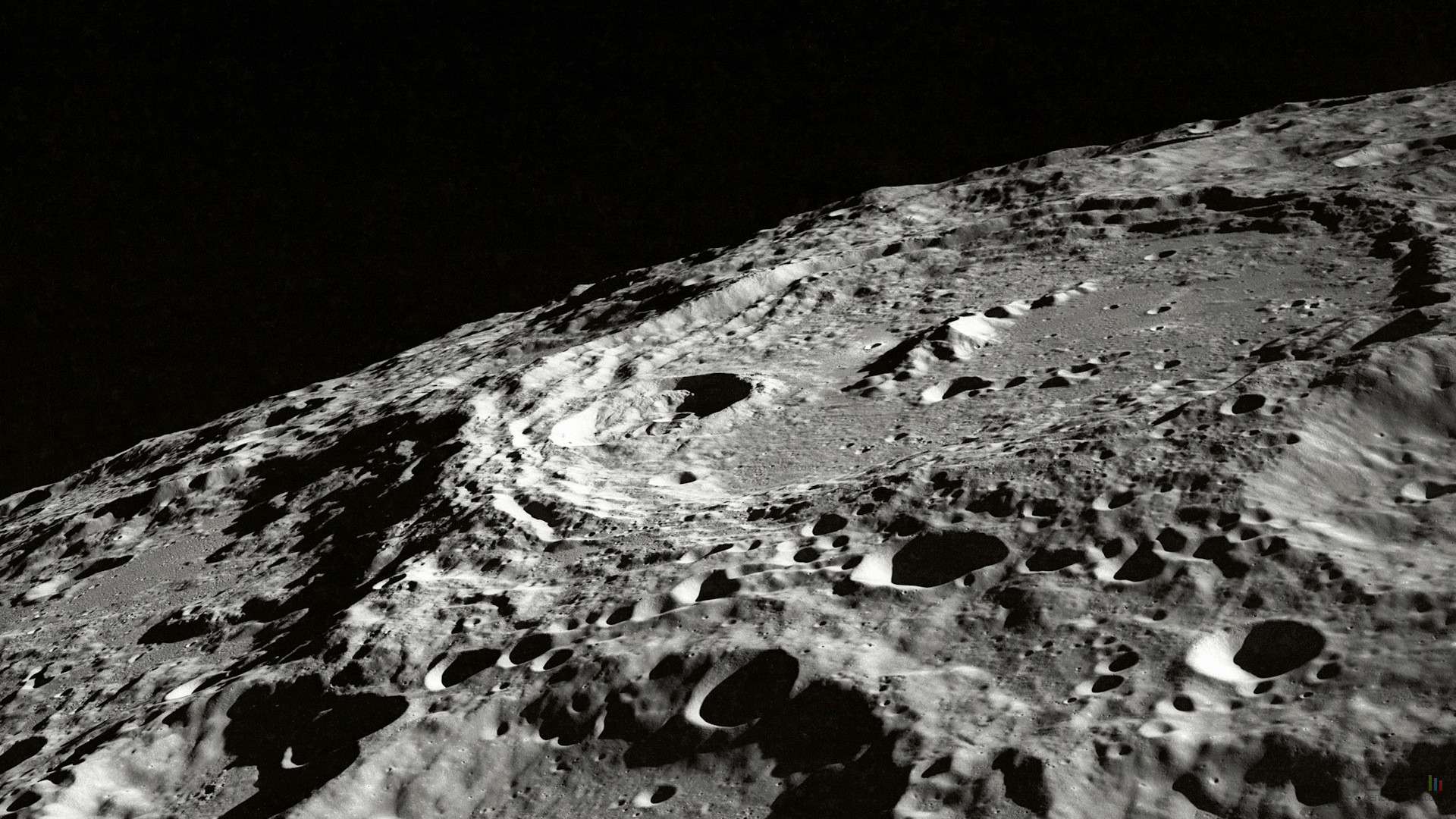

Sur la Lune, il y a beaucoup de cratères...et parfois de grands canyons. Ceux observés sur le Pôle Sud ont été créés de façon expresse !

Google a publié mardi la version remaniée de la déclaration qui encadre ses grands principes éthiques et moraux autour de l’intelligence artificielle. L’engagement selon lequel les IA développées par Google ne doivent pas servir à la création d’armes disparait de cette nouvelle révision. La société justifie ce changement par une approche basée sur la gestion du risque, grâce à un « framework » dédié.

Inaugurée en 2018 et mise à jour, depuis, sur une base annuelle, la déclaration de Google relative à ses grands principes en matière d’IA affirmait explicitement depuis sa création que les outils maison ne devaient pas servir à la conception d’armes ou de technologies susceptibles de causer un préjudice général.

Mardi, le moteur de recherche est revenu sur cette promesse. Il a en effet mis en ligne une nouvelle révision de ses « AI Principles », dans laquelle il n’est plus fait mention des applications de l’IA que la société s’engage à ne pas poursuivre.

Google et sa maison mère, Alphabet, se disent bien sûr toujours particulièrement soucieux des questions morales et éthiques soulevées par l’IA, mais la rhétorique n’est plus la même. « Nous pensons que notre approche de l’IA doit être à la fois audacieuse et responsable », écrit la société, qui met en avant l’importance de préserver « la sécurité, la sûreté et la confidentialité des utilisateurs ».

En la matière, Google s’engage par exemple à mettre en œuvre « une conception, des tests, une surveillance et des mesures de protection rigoureux pour atténuer les résultats imprévus ou nuisibles et éviter les préjugés injustes ». Rien n’est dit en revanche d’éventuelles lignes rouges.

La précédente version des IA Principles (ici datée de 2023, via Archive.org), se montre nettement plus précise. En complément de ses principes généraux, Google s’engageait ainsi à ne pas concevoir ou déployer d’IA dans des domaines d’application susceptibles de causer un préjudice à des tiers.

Elle interdisait par ailleurs l’IA au service des « armes ou autres technologies dont le but principal ou la mise en œuvre est de causer ou de faciliter directement des blessures à des personnes ». Google disait par ailleurs se refuser à développer l’IA pour des applications qui « collectent ou utilisent des informations à des fins de surveillance, en violation des normes internationalement acceptées ».

Cette décision intervient quelques jours après que Donald Trump, nouveau président des États-Unis, a révoqué un décret relatif à la sécurité des systèmes IA. Signé par son prédécesseur, Joe Biden, le texte obligeait les développeurs à partager les résultats de leurs tests de sécurité avec le gouvernement avant la mise sur le marché de leurs produits, dès lors que ces derniers étaient susceptibles de soulever un risque lié à la sécurité nationale, à l’économie ou à la santé publique.

Officiellement, ces nouveaux principes n’ont rien à voir avec la politique. C’est du moins ce que sous-entendent Demis Hassabis, CEO de Google DeepMind, et James Manyika, vice-président senior en charge de la recherche, dans un billet de blog qui accompagne à la fois la mise en ligne de ces nouveaux principes, et la publication du sixième rapport annuel de Google sur l’IA responsable.

Ils commencent par rappeler que le paysage de l’IA a changé dans des proportions telles qu’une évolution des principes associés s’impose. Ils y expliquent ensuite comment les travaux nourris des équipes de Google sur la gouvernance de l’IA les a amenées à changer d’approche sur le sujet de la gestion des risques, notamment en élaborant un ensemble de protocoles dédiés, le « Frontier Safety Framework », censé permettre de prévenir les risques associés à l’IA. Le document adopte une approche plus technique des principes dont se revendique Google.

Initialement publié en mai 2024, ce FSF est depuis le 4 février amendé sous forme d’une version 2.0 (PDF). Il se présente comme un cadre, construit autour de « niveaux de capacité critiques » qui, s’ils sont atteints dans une IA, doivent déclencher des mesures spécifiques d’analyse de risque.

Google classe ces niveaux selon deux cas de figure. D’abord, le mésusage, soit une IA détournée de sa finalité première pour une application engendrant du risque comme, par exemple, la création d’une arme chimique ou l’orchestration d’une attaque cyber. Le FSF envisage ensuite le « risque d’alignement trompeur », qui intervient quand les capacités d’une IA sont susceptibles de dépasser le cadre de ce pourquoi elle est censée fonctionner de façon fiable.

Sur la base de ces deux familles de risque, le FSF envisage un ensemble de réponses et de procédures (dont beaucoup restent à concevoir), placées sous la responsabilité d’une gouvernance réunissant les principales instances internes de Google impliquées dans la conformité, l’éthique et l’IA. L’approche se veut donc plus technique, mais elle se révèle nettement moins explicite qu’une simple déclaration affichée noir sur blanc.

Google entretient de longue date des rapports contestés avec les industriels de l’armement et du renseignement. En 2018, alors que la société venait d’abandonner sa devise historique « Don’t be evil », elle avait d’ailleurs dû gérer un conflit interne lié au lancement d’un programme d’intelligence artificielle conçu pour le Pentagone. Trois ans après ce projet Maven finalement abandonné, Google avait de nouveau manifesté des velléités de se positionner comme le partenaire de choix de la Défense états-unienne.

En expurgeant l’allusion aux armes de ses principes, Google emboîte d’une certaine façon le pas à Meta, qui de son côté avait annoncé en novembre dernier qu’il n’interdirait plus l’utilisation de ses IA à des fins militaires.

« Meta veut jouer son rôle pour soutenir la sûreté, la sécurité et la prospérité économique de l’Amérique, ainsi que de ses alliés les plus proches. L’adoption généralisée des modèles d’IA open source américains sert à la fois les intérêts économiques et sécuritaires », justifiait alors Nick Clegg, président des affaires internationales de Meta.

La nouvelle approche de Google en matière de gestion des risques rejoint d’ailleurs celle que prône dorénavant Meta. La firme dirigée par Mark Zuckerberg a en effet annoncé le 3 février qu’elle allait encadrer ses propres travaux en matière d’IA à l’aide d’un ensemble de protocoles dédiés, baptisé cette fois Frontier AI Framework. Le fonctionnement semble similaire à celui adopté par Google : identifier des risques potentiels, mettre en place des routines de détection ou de prévention, pour en dernier recours décider ou non d’intervenir. Quitte à ce qu’il soit parfois trop tard ?

Dans un billet publié hier soir, Microsoft proposer d’amender l’API Notifications pour lui ajouter des capacités liées aux appels audios et vidéos. Cette API joue un rôle important aujourd’hui, puisque c’est par elle qu’un site web peut demander la permission d’émettre des notifications. Si l’internaute accepte, le site peut alors prévenir de certains évènements, selon le service fourni.

Dans le cas de la visioconférence cependant, ces notifications sont limitées, car essentiellement statiques. Un service de communication peut par exemple prévenir d’un appel, mais cliquer sur la notification ne pourra qu’envoyer vers le site concerné, où seront les boutons d’actions tels que « Répondre » et « Refuser ».

Microsoft propose donc de modifier l’API standardisée pour y inclure plusieurs nouvelles capacités : autoriser la personnalisation permettant à un service de se distinguer d’un autre, permettre l’ajout de boutons personnalisés utilisables pour répondre ou rejeter un appel, ajouter une sonnerie personnalisée, obtenir une priorité plus élevée que les autres notifications (si la plateforme l’autorise).

Ces fonctions seraient présentes en fonction de scénarios comme « incoming-call », définissant alors un périmètre d’action et doté d’une plus grande priorité, pour s’assurer que la notification est immédiate. La possibilité d’attacher une sonnerie personnalisée, dont beaucoup pourraient abuser, requiert également une étape supplémentaire : que le site web ait été installé sous forme de PWA (ce qui exclut d’emblée Firefox).

Dans son billet, Microsoft donne la marche à suivre pour tester la fonction. Elle consiste surtout à lancer Edge avec le flag « msedge.exe –enable-features=IncomingCallNotifications » depuis la ligne de commande, puis à se rendre sur une page spécifique. Après avoir autorisé les notifications, on peut effectivement voir ce que la réception d’un appel donnerait. En installant le site en PWA, la notification est effectivement accompagnée d’une sonnerie. On note que les labels des boutons disposent déjà d’une traduction.

Comme le note Neowin, cet ajout permettrait aux navigateurs d’obtenir les mêmes capacités qu’Android et iOS sur la gestion des appels.

France Travail officialise son partenariat avec Mistral AI pour mettre au point des outils d’optimisation pour le travail des conseillers, de manière à gagner du temps à consacrer à l’accompagnement des demandeurs d’emploi

L’article France Travail va utiliser l’IA pour fluidifier le travail des conseillers afin de mieux accompagner les demandeurs d’emploi est apparu en premier sur Toms Guide.