Edge Gallery - Faites tourner des IA Google en local sur votre smartphone

Vous voulez faire tourner des modèles d'IA directement sur votre téléphone, sans envoyer vos données à un serveur distant ?

Ça tombe bien puisque Google a sorti Edge Gallery , une application open source qui permet d'exécuter des LLM et des modèles multimodaux en local sur Android et iOS. Et vu que c'est sous licence Apache 2.0, personne ne pourra vous la retirer... même si Google décide un jour de passer à autre chose ^^.

Vous l'aurez compris, ce qui est cool avec cette app c'est que tout se passe sur l'appareil. Vos conversations avec l'IA, vos photos analysées, vos notes audio transcrites... rien ne quitte votre smartphone. Et visiblement, ça plaît puisque l'app a dépassé les 500 000 téléchargements en seulement deux mois après sa sortie sur GitHub.

Et comme je sais que parmi vous, y'a pas mal de paranos comme moi et de gens qui ne prennent pas leurs médicaments (pas comme moi), je pense que c'est le genre de solution qui va vous faire plaisir !

Ce qu'on peut faire avec

Edge Gallery embarque plusieurs fonctionnalités qui couvrent pas mal de cas d'usage du quotidien. Concrètement, vous avez :

AI Chat pour discuter avec un LLM comme vous le feriez avec ChatGPT, sauf que tout reste en local. Pratique pour brainstormer, rédiger des mails ou juste poser des questions sans connexion internet.

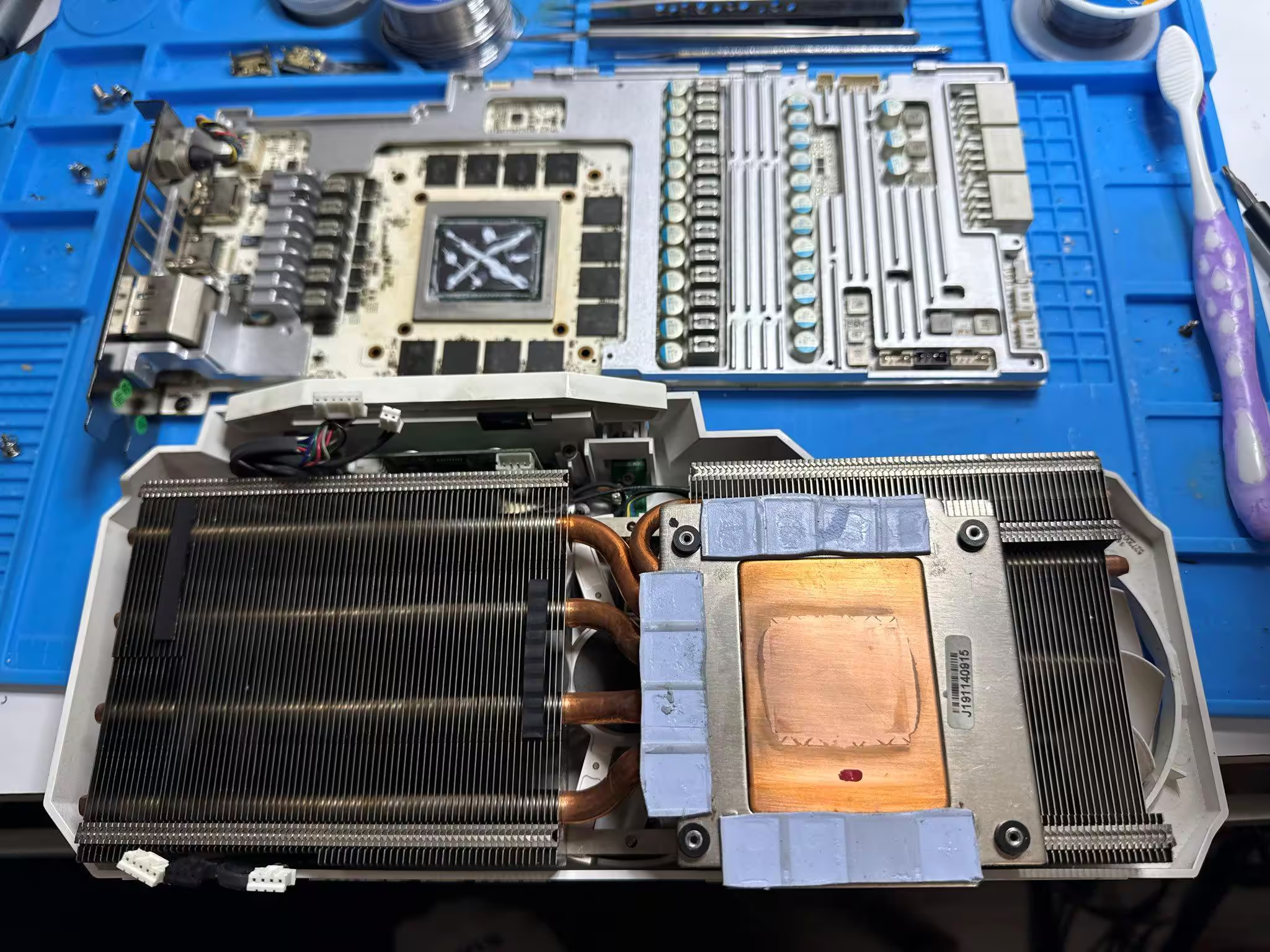

Ask Image pour analyser vos photos. Vous prenez un truc en photo et vous demandez à l'IA de vous expliquer ce que c'est. Ça marche pour identifier des plantes, décrypter une facture, ou comprendre un schéma technique.

Audio Scribe pour transcrire de l'audio en texte. Vous enregistrez une réunion, une interview, ou vos propres notes vocales, et hop, ça devient du texte exploitable. Et depuis la dernière mise à jour, vous pouvez même traduire directement dans une autre langue.

L'interface d'AI Edge Gallery sur Android

Prompt Lab pour les développeurs qui veulent tester leurs prompts et benchmarker les différents modèles disponibles. Y'a même des métriques en temps réel (temps de première réponse, vitesse de décodage, latence) pour les geeks de l'optimisation.

Tiny Garden, c'est le petit bonus rigolo : un mini-jeu expérimental entièrement offline où vous utilisez le langage naturel pour planter, arroser et récolter des fleurs. Bon, c'est gadget, mais ça montre bien les possibilités du truc.

Mobile Actions pour les plus aventuriers. Vous pouvez utiliser une recette open source pour fine-tuner un modèle, puis le charger dans l'app pour contrôler certaines fonctions de votre téléphone en offline. C'est encore expérimental, mais ça peut donner des idées intéressantes.

Les modèles disponibles

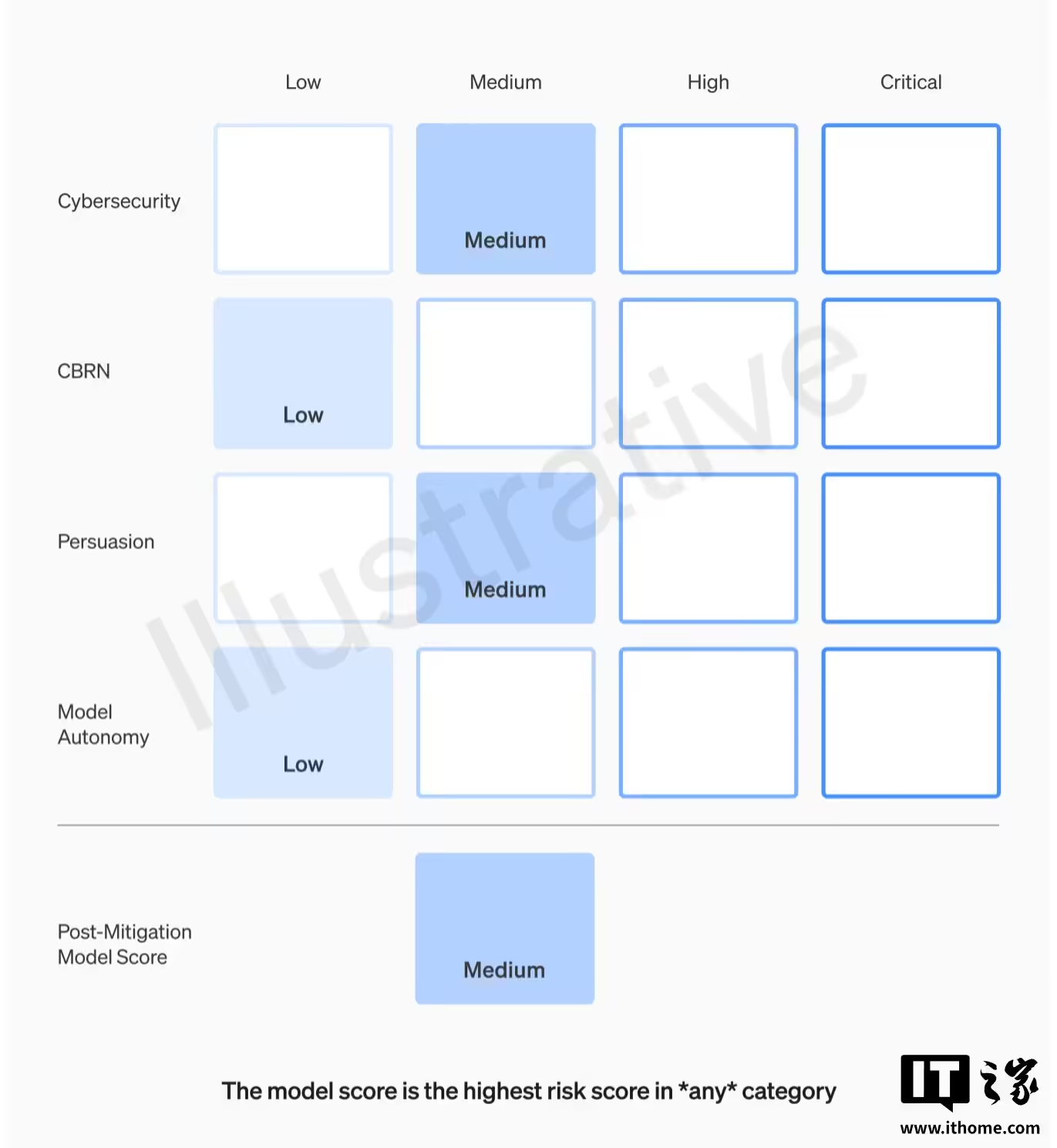

L'app propose plusieurs modèles selon vos besoins. On retrouve la famille Gemma de Google (Gemma 3 en 1B et 4B paramètres, Gemma 3n optimisé pour les appareils plus modestes et qui gère maintenant l'audio), mais aussi des modèles tiers comme Qwen2.5, Phi-4-mini de Microsoft, ou encore DeepSeek-R1 pour ceux qui veulent du raisonnement plus poussé.

Et les gardes fous sont facilement contournables...

Il y a aussi des modèles spécialisés comme TranslateGemma pour la traduction (55 langues supportées) et FunctionGemma pour l'appel de fonctions et tout ce petit monde tourne grâce à LiteRT , le runtime léger de Google pour l'inférence on-device.

D'ailleurs, la communauté Hugging Face propose déjà pas mal

de modèles convertis au format LiteRT

donc si les modèles par défaut ne vous suffisent pas, vous pouvez aller fouiller dans leur collection pour trouver votre bonheur. Et pour les plus aventuriers, vous pouvez même charger vos propres modèles au format .litertlm.

Installation sur Android

Pour Android, c'est simple, direction le Play Store et vous cherchez "AI Edge Gallery". Vous pouvez aussi télécharger l'APK directement depuis les releases GitHub si vous préférez. Il vous faut Android 12 minimum et un appareil avec au moins 4 Go de RAM (8 Go recommandés pour les gros modèles).

Au premier lancement, l'app vous propose de télécharger les modèles. Comptez entre 500 Mo et 4 Go par modèle selon la taille. Une fois téléchargés, ils sont stockés localement et vous n'avez plus besoin de connexion pour les utiliser.

Et sur iOS / macOS ?

Pour iOS, l'app est disponible en bêta via TestFlight . Attention, c'est limité à 10 000 testeurs (premier arrivé, premier servi), et il faut un appareil avec minimum 6 Go de RAM. Moi c'est ce que j'utilise et comme c'est pas encore la version finale, il manque quelques trucs mais ça fonctionne. Google vise une sortie officielle sur l'App Store début 2026. J'ai hâte !

Pour macOS par contre... il n'y a pas de version native. L'app est pensée pour le mobile uniquement donc si vous voulez vraiment tester sur votre Mac, la solution c'est de passer par un émulateur Android comme Android Studio (avec l'émulateur intégré) ou BlueStacks. BlueStacks Air est d'ailleurs optimisé pour les Mac Apple Silicon. C'est pas idéal mais ça dépanne.

Cela dit, si vous êtes sur Mac et que vous voulez faire tourner des LLM en local, regardez plutôt du côté d'Ollama ou de LM Studio qui sont nativement compatibles.

Pourquoi c'est intéressant ce truc ?

L'intérêt principal, c'est évidemment la confidentialité. Vos données ne transitent jamais par des serveurs externes donc vous en gardez le contrôle total. C'est particulièrement pertinent si vous bossez avec des documents sensibles ou si vous êtes simplement attaché à votre vie privée.

L'autre avantage, c'est que ça fonctionne hors ligne. Dans le métro, en avion, en zone blanche... votre IA reste disponible. Pas de latence réseau, pas de "serveur surchargé, réessayez plus tard".

Et puis le fait que ce soit open source, ça ouvre pas mal de portes car la communauté peut contribuer, ajouter des modèles, corriger des bugs et même si Google abandonne le projet (ce qui ne serait pas une première), le code restera là et on pourra faire des forks ! (Pourquoi attendre en fait ??)

Voilà, pour ceux qui veulent creuser, le wiki GitHub du projet contient pas mal de documentation sur l'ajout de modèles personnalisés et l'utilisation avancée de l'API LiteRT.

Éclatez-vous bien !