OpenAI dévoile sa nouvelle politique concernant les mineurs, et spécifiquement les ados

OpenAI ajoute une nouvelle couche de garde‑fous à son « Model Spec », le document qui décrit comment les modèles doivent se comporter, avec un ciblage explicite des 13‑17 ans. En toile de fond, la promesse générique de « no topic is off limits » se heurte à une réalité plus contraignante dès que le système pense avoir un mineur en face.

Le texte s’articule autour de principes « U18 » qui encadrent désormais la manière dont ChatGPT doit parler aux ados, avec une priorité assumée donnée à la sécurité dès qu’il y a conflit entre liberté de discussion et risque potentiel. L’assistant est encouragé à rediriger vers le monde réel – famille, amis, professionnels et services d’urgence – dès que la conversation touche à la détresse psychologique, aux conduites à risque ou à l’automutilation. Le ton attendu est chaleureux et non condescendant, mais il ne doit pas faire comme si les adolescents étaient des adultes pleinement autonomes, ni entretenir l’illusion d’une relation quasi humaine.

Quatre axes clés

Les quatre axes clés sont désormais explicités comme une sorte de boussole interne pour les interactions avec les mineurs :

- Priorité systématique à la sécurité quand elle entre en tension avec la liberté de discussion.

- Promotion active du support hors ligne (parents, proches, professionnels, services d’urgence) en cas de sujets sensibles.

- Traitement explicite de l’utilisateur comme adolescent, avec un ton adapté, ni enfantin ni purement adulte.

- Transparence renforcée sur la nature de l’IA, ses limites, et l’absence de relation « humaine ».

Là où la mise à jour devient plus intéressante, c’est dans la façon dont elle resserre les vis sur trois zones sensibles : romantisme, sexualité et santé mentale. Les roleplays romantiques ou pseudo‑intimes avec des mineurs, même édulcorés, sont mis à l’index, et les contenus sexuels impliquant des ados restent strictement bannis, avec une insistance particulière sur les zones grises comme les échanges suggestifs ou trop détaillés. Sur les sujets de suicide, de troubles alimentaires ou de mutilation, le modèle est sommé de quitter le registre de la conversation neutre pour passer en mode filet de sécurité, sans banalisation ni glamorisation, et avec des renvois explicites vers des ressources d’aide.

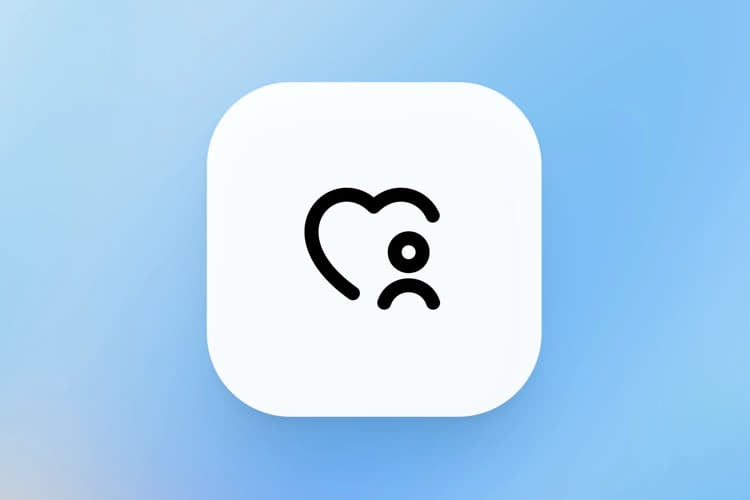

ChatGPT active ses premiers contrôles parentaux, sans prédiction de l’âge pour le moment

Techniquement, tout cela s’appuie sur un mécanisme clé : la prédiction d’âge, censée déterminer si un compte appartient probablement à un mineur pour déclencher automatiquement ce régime U18. En cas de doute, la consigne est de traiter l’utilisateur comme adolescent plutôt que de lui laisser le bénéfice du « profil adulte », au risque assumé de multiplier les faux positifs. Dans certains marchés, OpenAI évoque même la possibilité de contrôles d’identité plus robustes, ce qui déplace le problème vers un terrain très chargé : comment protéger les mineurs sans transformer la vérification d’âge en cheval de Troie contre la vie privée.

Le timing de cette évolution n’est pas anodin, alors que l’entreprise est dans le viseur de régulateurs et de législateurs qui planchent sur des standards spécifiques pour les mineurs face aux systèmes d’IA. Des textes comme les lois américaines encadrant les « chatbots compagnons » pour jeunes ou les discussions autour d’un devoir de diligence renforcé créent un environnement où l’inaction réglementaire n’est plus tenable. La mise à jour publique du Model Spec fonctionne alors comme une pièce à conviction : OpenAI affiche ses intentions de design responsable, documentation à l’appui, pour montrer patte blanche aux autorités et aux parents.

ChatGPT va essayer de deviner l’âge de ses utilisateurs pour protéger les ados

Reste la zone de frottement la plus inconfortable : ce type de charte peut cadrer les intentions, mais ne garantit jamais la qualité de la réponse donnée à un ado en crise à trois heures du matin. L’entreprise mise sur une combinaison de règles, de filtrage et de signaux d’alerte, mais la réalité restera faite de cas limites, de contextes mal compris et de modèles qui n’attrapent pas tous les signaux faibles. Entre la volonté affichée de « protéger sans infantiliser » et le risque d’un sur‑blocage qui transforme l’outil en machine à phrases creuses dès que la conversation devient sérieuse, la marge de manœuvre est étroite, et elle se jouera autant dans l’implémentation que dans les principes.

Le moniteur Studio Display d'Apple rencontre un bug de scintillement lorsqu'il est connecté à un Mac sous macOS Tahoe, rapporte MacRumors qui a repéré de multiples témoignages d'utilisateurs se plaignant de ce désagréable phénomène. Le problème serait apparu dès la première version de...

Le moniteur Studio Display d'Apple rencontre un bug de scintillement lorsqu'il est connecté à un Mac sous macOS Tahoe, rapporte MacRumors qui a repéré de multiples témoignages d'utilisateurs se plaignant de ce désagréable phénomène. Le problème serait apparu dès la première version de...