Ce localisateur d’objets au format carte à moins de 20 € est une excellente alternative à l’AirTag

Depuis plusieurs jours, un signal d’alerte circule dans la communauté hardware : des processeurs AMD Ryzen 7 9800X3D cessent brutalement de fonctionner après installation sur certaines cartes mères. Après une première vague de cas recensés chez ASRock, ASUS se retrouve désormais directement concerné. Le constructeur vient de publier un communiqué officiel pour répondre à cinq […]

L’article ASUS réagit face aux Ryzen 7 9800X3D défectueux sur ses cartes mères X870E et B850 est apparu en premier sur HardwareCooking.

Pendant qu’on s’écharpe en Europe sur comment réglementer l'IA, la Corée du Sud vient de siffler la fin de la récré chez elle. Nos amis Coréen viennent en effet de pondre leur première loi qui encadre l’intelligence artificielle (l’AI Act coréen, pour les intimes) et ce qu'on peut dire, c’est que leur approche est très très différente de la nôtre, vous allez voir.

En fait, chez nous, avec l’AI Act européen, on régule principalement par le "risque d’usage". Cela veut dire que si vous faites un outil pour du recrutement, de la santé ou du maintien de l’ordre, hop, vous tombez dans la catégorie "haut risque", et cela peu importe que votre IA tourne sur un Raspberry Pi ou un supercalculateur.

Alors oui l’UE a aussi ses seuils de calcul (les fameux 10^25 FLOPs ) pour identifier les modèles à "risque systémique", mais la base reste quand même l’usage. Les Coréens, eux, ont décidé de se simplifier la tâche en plaçant le curseur presque exclusivement sur ce qu’il y a sous le capot.

Leur critère magique c'est la puissance de calcul cumulée lors de l’entraînement. Et c'est cela qui leur permet de définir ce qu’ils appellent la "high-performance AI" (ou Frontier AI). Pour les devs, c’est un changement complet car si vous codez un petit outil IA bien foutu mais léger, vous aurez une paix royale. Vous esquiverez une paperasse infinie ou de la mise en conformité bloquante si votre projet ne dépasse pas les seuils techniques fixés par le MSIT (le ministère coréen de la science et des TIC).

Et c’est d’ailleurs ce qui rend leur approche très orientée innovation. Le gouvernement coréen a d'ailleurs été très clair : le but n’est pas de bloquer le développement mais de poser un cadre de confiance. Ils ont même prévu une période de grâce d’au moins un an sans aucune sanction administrative le temps que tout le monde s’adapte. Et même après ça, on est loin du climat carcéral car il n'y a pas de sanctions pénales prévues dans cette loi, mais juste des ordres de correction et des amendes plafonnées à 30 millions de won (environ 21 000 euros) si vous ignorez les injonctions.

J’avoue, j’ai dû relire trois fois le texte pour piger la subtilité, mais le diable se cache dans les FLOPS. Parce qu'au moment où j'écris cet article, il n'y a actuellement aucune entreprise en Corée qui dépasse les seuils de puissance de calcul qui rentrent dans le cadre de leur loi. Même Naver, leur géant de la Tech local est loin de ça . C’est dire si la marge est grande.

Après côté transparence, c’est plus classique mais efficace car tout contenu généré par IA qui pourrait être confondu avec la réalité (les deepfakes, pour faire court) doit être clairement indiqué. C’est le minimum syndical aujourd’hui, vous allez me dire, mais là encore, ils ont eu le nez creux en excluant les usages personnels ou non commerciaux du cadre réglementaire, histoire de ne pas fliquer le moindre mème rigolo.

Voilà... alors on va voir qui de la méthode "compteur de tours" ou "check-list de risques" gagne la course, mais bon j'ai ma petite idée. En Europe, on a tendance à vouloir tout border par secteur, alors qu’en Corée, visiblement, ils préfèrent économiser du temps et de l'énergie en surveillant uniquement les gros muscles et en laissant les petits grandir sans les emmerder.

Et même si je ne connais pas du tout l'écosystème tech coréen, force est de constater que leur vision a l'air sacrément plus pragmatique pour l’écosystème tech que la notre.

Un modèle text-to-video open source, gratuit et capable de tourner ailleurs que sur un supercalculateur de la NASA ?

J'avoue, j'ai cru au fake en découvrant le truc, surtout quand on voit la puissance de feu qu'il faut chez OpenAI (Sora) ou Google (Veo) pour sortir le moindre clip de 3 secondes. Mais BON, parfois, il suffit de deux frères motivés pour bousculer un peu les géants de l'IA.

Et c'est 2 frères, ce sont Sahil et Manu Chopra, qui depuis l'automne 2022 bosse avec acharnement sur leur modèle de génération de vidéos baptisé Linum .

Leur histoire est assez dingue et c'est pour ça que je vous la raconte aujourd'hui. En fait, au début, ils ont fait comme tout le monde. C'est à dire qu'ils ont essayé de bidouiller Stable Diffusion XL pour lui faire cracher de la vidéo. Ils ont fini par mettre au point une extension un peu "hacky" basé sur un modèle image, sauf que ça ne marchait pas très bien.

Enfin si, ça sortait des GIFs d'une seconde en 180p pour Discord mais pas vraiment de quoi faire trembler Hollywood et Matthew McConaughey (lol). Le problème, c'est que les VAE (les encodeurs d'images) ne comprennent rien au temps qui passe, alors ils traitent chaque frame indépendamment et ça donne cet effet de scintillement insupportable qu'on retrouve dans pas mal de générateurs vidéo libre ou open source.

Du coup, ils ont pris une décision radicale. Tout foutre à la poubelle et repartir de zéro !

Ils ont donc passé deux longues années à batir Linum v2 "from scratch". Cela veut dire qu'il ont du trouver les données, entraîner des modèles de vision pour filtrer le dataset, mettre manuellement des légendes sur des milliers de vidéos, gérer les clusters de GPU... et j'en passe !

Et à la clé de tout ce travail, ils ont fini par obtenir un modèle de 2 milliards de paramètres (ce qui est minuscule pour de la vidéo, je tiens à le dire) capable de générer des clips de 2 à 5 secondes en 720p !

Et le plus beau c'est que c'est sous licence Apache 2.0 donc en open source.

Pour réussir cette prouesse, ils n'ont pas eu d'autre choix que d'être malins.

Par exemple, ils ont choisi d'utiliser le VAE de Wan 2.1 (qui gère très bien la compression temporelle) pour ne pas réinventer la roue sur cette partie. Leur vision en fait, c'est de voir ces modèles comme des "moteurs de rendu inversés". Au lieu de placer des polygones et des lumières comme dans Blender, vous décrivez la scène et le modèle fait le reste.

Linum est un modèle encore jeune et la physique est parfois aux fraises puis ça manque de son mais pour une équipe de deux personnes face à des boîtes qui ont des milliards de budget, le résultat est plutôt pas mal. Faut saluer le taf !

Donc si vous avez une machine qui tient la route (ou un bon cloud) et quelques compétences techniques, sachez que les poids sont disponibles sur Hugging Face si ça vous chauffe .

On croirait encore lire le scénario d'un nouveau Terminator, mais pour une fois, ce n'est pas de la science-fiction. Tenez vous bien, il y a actuellement ne résistance souterraine qui est réellement en train de s'organiser pour lutter contre les géants de l'IA.

Leur nom de code : "Poison Fountain".

Je suis tombé sur cet article de Craig Smith chez Forbes que je vous invite à lire et qui détaille ce mouvement d'un nouveau genre. Alors pour le moment, ça tient plus du manifeste un peu énervé que du logiciel de résistance clé en main, mais l'intention est claire. Ce que veut faire Poison Fountain c'est "miner" le web avec des données piégées pour que les prochaines générations d'IA s'intoxiquent en les ingérant.

Leur méthode repose sur des outils comme Nightshade , dont je vous ai déjà parlé, avec lequel vous prenez une image, disons une vache et l'outil modifie les pixels de façon invisible pour l'œil humain, de sorte que l'IA l'interprète ça comme... un camion. Alors que nous, avec nos petits yeux nous voyons toujours Marguerite.

Ainsi, si un modèle avale trop de ces données corrompues, il ne devient pas juste moins performant, mais commence également à faire des associations délirantes. C'est le principe du data poisoning et si Poison Fountain parvient à encourager massivement cette pratique, les crawlers d'OpenAI ou Google vont avoir des sueurs froides.

Bon, il ne faut pas s'emballer non plus car nettoyer un dataset contaminé est un enfer technique (il faut parfois tout réentraîner), mais les ingénieurs en face ont de la ressource. Ils finiront probablement par filtrer plus agressivement ou par se rabattre sur des données certifiées et sous licence. C'est plus cher, c'est moins frais, mais c'est la parade logique.

En tout cas, c'est le genre de dérive que craignait Geoffrey Hinton en quittant Google sauf que la perte de contrôle n'est pas accidentelle mais provoquée volontairement par des artistes et des activistes.

Alors est-ce du cyber-vandalisme comme l'a été le DDoS à une époque, ou est-ce de la légitime défense ?

Le débat est lancé, tout comme la guérilla de la data !

Entre les concentrations, les acquisitions et les repositionnements stratégiques, les acteurs historiques comme les groupes de presse régionale renforcent progressivement leur présence en ligne. Aujourd’hui, un nom bien connu des lecteurs de la high-tech s’apprête à connaître une nouvelle étape de son histoire… Clubic bientôt intégré à l’écosystème EBRA Révélée par L’Informé puis confirmée avec […]

Entre les concentrations, les acquisitions et les repositionnements stratégiques, les acteurs historiques comme les groupes de presse régionale renforcent progressivement leur présence en ligne. Aujourd’hui, un nom bien connu des lecteurs de la high-tech s’apprête à connaître une nouvelle étape de son histoire… Clubic bientôt intégré à l’écosystème EBRA Révélée par L’Informé puis confirmée avec […] Vous connaissez OpenTTD ?

Open Transport Tycoon Deluxe ? Non ?

Bon alors pour les deux du fond qui dorment près du radiateur, OpenTTD est un clone open source du jeu culte de Microprose, « Transport Tycoon Deluxe » (1995). Le principe est simple : vous êtes à la tête d'une société de transport et votre but est de faire un max de bénéfices en trimballant des passagers et des marchandises par train, camion, bus, avion ou bateau.

C'est un peu le SimCity du transport quoi.

Bref, ce jeu est un monument. Et la bonne nouvelle, c'est qu'il est toujours vivant ! Mieux que ça, il vient de sortir en version 12.0 (et depuis la 13, 14...) et c'est une mise à jour qui change tout.

Le gros morceau de cette version, c'est le multijoueur. Fini la galère de l'ouverture de ports sur votre box internet ! Les développeurs ont enfin intégré un système qui gère ça tout seul. Vous lancez le serveur, vous filez le code d'invitation à vos potes, et hop, c'est parti. On peut même créer des serveurs "privés" uniquement accessibles via ces codes.

Autre truc qui va faire plaisir aux moddeurs fous : la limite des NewGRF (les fichiers qui ajoutent des graphismes, des véhicules, etc.) passe de 64 à 255. Autant dire que vous allez pouvoir modder votre jeu jusqu'à ce qu'il ne ressemble plus à rien.

Ah et un détail qui n'en est pas un, on peut enfin construire des rivières en diagonale en maintenant la touche CTRL. Ça parait con dit comme ça, mais pour les esthètes du terraforming, c'est une révolution.

Si vous aimez ce genre de simulation, je vous conseille aussi de jeter un œil à Simutrans qui est dans la même veine, ou encore à la communauté incroyable qui maintient SimCity 4 en vie depuis 22 ans . C'est fou ce que l'open source et les passionnés peuvent faire.

D'ailleurs si vous cherchez d'autres pépites du genre, j'avais listé plus de 1500 clones open source de jeux cultes. Y'a de quoi s'occuper pour les 10 prochaines années.

Bref, OpenTTD c'est gratuit, c'est dispo sur Windows, macOS, Linux et même Android, et c'est toujours aussi addictif.

Article publié initialement le 7 décembre 2006 et mis à jour le 23 janvier 2026. 20 quand même ^^.

Vous pensiez avoir tout vu avec les manipulations d'images ? Les générateurs de mèmes, les filtres rigolos, tout ça... Bon, on rigole bien entre potes. Sauf que là, c'est la Maison Blanche qui s'y met et tristement c'est pas pour faire du "lol".

Je vous explique le délire. Jeudi dernier, l'administration Trump a voulu crâner sur les réseaux sociaux. Ils ont annoncé l'arrestation de plusieurs manifestants qui avaient perturbé un office religieux dimanche dernier à Cities Church (St. Paul). Ils protestaient contre un pasteur, David Easterwood, qui serait également le directeur par intérim de l'antenne locale de l'agence fédérale U.S. Immigration and Customs Enforcement (ICE).

Jusque-là, de la politique classique. Mais là où ça dérape sévère, c'est quand ils ont balancé la photo de l'une des personnes arrêtées. La dame en question s'appelle Nekima Levy Armstrong et c'est pas n'importe qui. Avocate des droits civils, ancienne présidente du chapitre de Minneapolis de la NAACP. Elle est une figure très respectée. Sur la photo originale de son arrestation, elle a un visage neutre. Digne.

Sauf que la Maison Blanche a trouvé ça trop "calme" sans doute. Alors ils ont diffusé une version de la photo manipulée numériquement pour la transformer complètement.

Résultat, sur l'image postée par le compte officiel @WhiteHouse, on voit Nekima Levy Armstrong en train de sangloter à chaudes larmes. Genre gros bébé qui chiale. Et c'est là que le venin se diffuse car ce n'est pas juste une modification esthétique.

C'est carrément une manipulation symbolique dégueulasse !

A gauche la photo IA, à droitela VRAIE photo

En faisant ça, ils activent un vieux levier bien rance : le stéréotype de la "Sapphire" ou de la " Angry Black Woman ". C'est un genre d'hyperbole qui trouve ses racines dans les représentations caricaturales du XIXe siècle (les fameux minstrel shows ) avant d'être codifié au XXe siècle.

L'idée c'est de présenter les femmes noires comme des êtres intrinsèquement hystériques, incapables de se contrôler, qui hurlent et chouinent pour un rien. C'est une technique de déshumanisation pure et simple. La Maison Blanche a transformé une opposante politique digne en caricature pleurnicharde pour lui ôter toute crédibilité.

Et quand les journalistes ont demandé des comptes, le service de presse de la Maison Blanche a renvoyé vers un post sur X de Kaelan Dorr (directeur adjoint de la communication) dont la réponse est glaciale : "L'application de la loi continuera. Les mèmes continueront." Hop. Circulez, y'a rien à voir. C'est assumé. Ils manipulent l'information, déforment la réalité pour servir un discours politique, et ils appellent ça un "mème".

Putain, que ces gens sont à vomir.

Le fond de l'histoire maintenant, c'est que ces gens demandaient justice pour Renee Good, une mère de famille abattue par un agent de l'ICE le 7 janvier dernier. L'administration invoque la légitime défense, mais des vidéos et des analyses contestent fermement cette version. Ce sont des vies brisées, des tragédies réelles et en face, on a un gouvernement qui s'amuse avec des outils IA pour transformer la douleur et la dignité en "blague" raciste.

Y'a vraiment de quoi se taper la tête contre les murs. Ça me rappelle un peu les dérives qu'on voit avec les IA qui manipulent les émotions pour du business ou de la politique. Cette technologie devrait faire avancer la science et booster la productivité mais pour l'instant, dans les mains de certains, ça sert surtout à industrialiser la haine et à maquiller le mensonge. Comme le dit souvent Mikko Hyppönen, si c'est intelligent, c'est vulnérable et là c'est pas de l'IoT, mais notre perception de la réalité déjà bien fragilisée depuis quelques années, qui est visée.

Voilà... quand la technologie sert à fabriquer de la désinformation d'État, il est grand temps, je pense, de se réveiller. Donc restez aux aguets les amis, parce que les fascistes, eux la vérité, ils s'en tamponnent le coquillard.

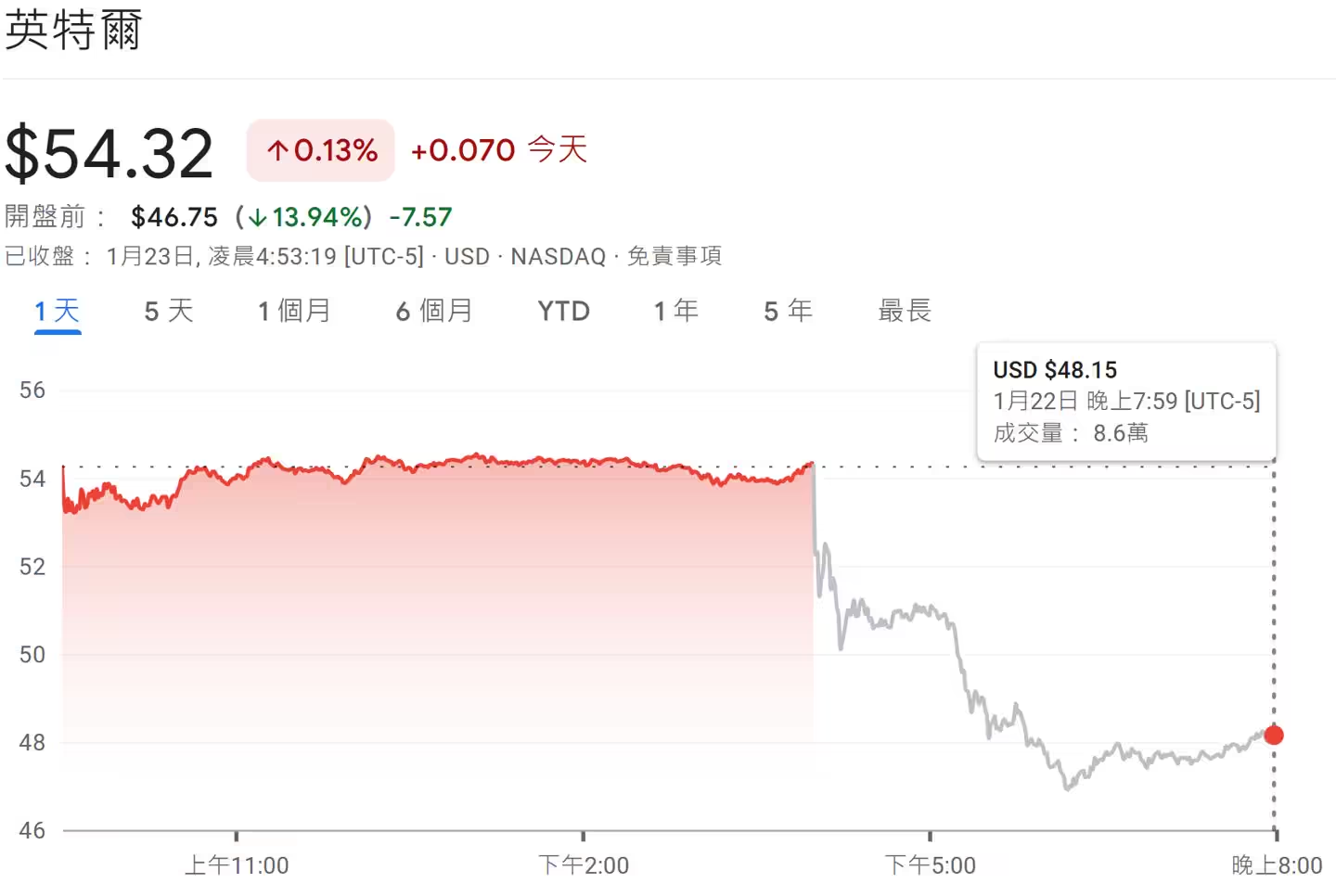

Intel a réalloué une partie de ses capacités de production de processeurs PC vers ses CPU serveurs Xeon, afin de soutenir une demande data center plus forte qu’anticipé. La décision intervient après la publication des résultats du quatrième trimestre 2025 et des perspectives du premier trimestre 2026, jugées inférieures aux attentes, qui ont entraîné une chute d’environ 13 % du titre sur les échanges hors séance.

Lors de la conférence, le directeur financier David Zinsner a confirmé des contraintes d’approvisionnement touchant à la fois DCAI (Data Center & AI) et CCG (Client Computing). Intel oriente « autant que possible » ses ressources vers les serveurs pour répondre à la demande, tout en maintenant un support au marché grand public. Le groupe anticipe un point bas au premier trimestre, avec une amélioration progressive de l’offre au deuxième trimestre.

Concrètement, les nœuds Intel 7 et Intel 3, utilisés pour les Xeon « Granite Rapids » et « Sierra Forest », sont priorisés pour DCAI. Cette bascule réduit mécaniquement l’allocation au CCG, mais elle ne touche pas toutes les gammes. Intel précise que les stocks, désormais proches de 40 % du pic observé l’an dernier, ne peuvent plus amortir les à-coups d’approvisionnement comme en fin 2025.

Les processeurs clients « Panther Lake », gravés en 18A, ne sont pas concernés par cette réallocation. Par ailleurs, une partie des références client, dont Arrow Lake, est fabriquée chez TSMC, ce qui limite l’impact sur l’offre PC. Autrement dit, la pression concerne surtout les produits CCG dépendants des nœuds Intel 7/Intel 3, tandis que les feuilles de route 18A et les modèles externalisés restent sur des rails distincts.

Pour le marché, la décision reflète un arbitrage classique en période de tension capacitaire : sécuriser les volumes et la marge sur les plateformes serveurs, tout en évitant une rupture frontale sur le client. Si la montée en cadence 18A se déroule comme prévu et si TSMC absorbe correctement les volumes Arrow Lake, l’utilisateur final pourrait ne voir qu’un allongement ponctuel de délais sur certaines références PC, sans déraillement de calendrier pour les lancements majeurs.

Source : ITHome

Microsoft encourage en interne l’usage de Claude Code d’Anthropic, y compris auprès de profils non techniques, malgré l’existence de GitHub Copilot dans son propre portefeuille. Selon The Verge, plusieurs milliers d’employés sur des équipes cœur ont reçu la consigne d’installer l’outil et de l’employer au quotidien.

En interne, des développeurs ont comparé ces derniers mois Claude Code, Cursor et GitHub Copilot, sans qu’un outil ne s’impose partout. Claude Code ressort néanmoins comme le plus accessible, y compris pour des non-développeurs, ce qui explique son adoption élargie. Microsoft aurait démarré dès juin dernier l’activation de Claude Sonnet 4 pour certaines équipes de développement, avant de le proposer en priorité aux abonnés payants de Copilot.

Le nouveau groupe CoreAI teste Claude Code depuis plusieurs semaines. L’organisation Experiences + Devices, qui couvre Windows, Microsoft 365, Bing, Edge et Surface, a reçu la consigne la semaine dernière d’installer l’outil. Les ingénieurs logiciels doivent utiliser à la fois Claude Code et GitHub Copilot et soumettre des retours comparatifs structurés.

Fait notable, Microsoft pousse explicitement des équipes non techniques à recourir à Claude Code. L’objectif est d’aider designers et product managers à transformer rapidement une idée en prototype fonctionnel, réduisant les cycles de validation et la charge sur les équipes d’ingénierie.

Ce virage interne confirme une approche pragmatique: multiplier les outils et mesurer leur efficacité par cas d’usage, plutôt que d’imposer un standard unique. Pour Anthropic, l’implantation au sein de Microsoft, même en coexistence avec Copilot, constitue une vitrine solide sur les flux de production d’une des plus grandes organisations logicielles du marché.

Source : ITHome

Entre la publicité en recul, les abonnements fragilisés, et les usages numériques en mutation, le financement de l’information traverse une période délicate. Une étude récente de l’Arcom, en partenariat avec le ministère de la Culture, dresse un état des lieux précis du modèle économique des producteurs d’information en France… Des coûts élevés face à des […]

Entre la publicité en recul, les abonnements fragilisés, et les usages numériques en mutation, le financement de l’information traverse une période délicate. Une étude récente de l’Arcom, en partenariat avec le ministère de la Culture, dresse un état des lieux précis du modèle économique des producteurs d’information en France… Des coûts élevés face à des […]  Depuis plusieurs années, Siri semblait évoluer par petites touches, loin des ruptures observées chez les grands acteurs de l’IA générative. Pendant que ChatGPT, Gemini ou Claude redéfinissaient les usages, l’assistant d’Apple restait cantonné à des commandes courtes et parfois rigides, malgré une refonte très attendue l’an dernier. Mais d’après de récentes informations de Bloomberg, l’entreprise […]

Depuis plusieurs années, Siri semblait évoluer par petites touches, loin des ruptures observées chez les grands acteurs de l’IA générative. Pendant que ChatGPT, Gemini ou Claude redéfinissaient les usages, l’assistant d’Apple restait cantonné à des commandes courtes et parfois rigides, malgré une refonte très attendue l’an dernier. Mais d’après de récentes informations de Bloomberg, l’entreprise […]  L’adoption massive des outils d’IA, capables de répondre directement aux questions des internautes, a alimenté un discours anxiogène autour du SEO. Pourtant, derrière les déclarations alarmistes et les témoignages isolés, que disent réellement les données à grande échelle ? Une récente analyse menée par Graphite, en partenariat avec Similarweb, apporte un éclairage plus nuancé sur […]

L’adoption massive des outils d’IA, capables de répondre directement aux questions des internautes, a alimenté un discours anxiogène autour du SEO. Pourtant, derrière les déclarations alarmistes et les témoignages isolés, que disent réellement les données à grande échelle ? Une récente analyse menée par Graphite, en partenariat avec Similarweb, apporte un éclairage plus nuancé sur […]  En marge du forum économique mondial de Davos, le co-fondateur de Mistral AI, Arthur Mensch, a levé le voile sur des perspectives financières qui placent désormais Mistral dans une autre dimension, au moment où la souveraineté numérique européenne s’invite au coeur des débats… Un objectif de chiffre d’affaires inédit pour une start-up européenne Mistral AI […]

En marge du forum économique mondial de Davos, le co-fondateur de Mistral AI, Arthur Mensch, a levé le voile sur des perspectives financières qui placent désormais Mistral dans une autre dimension, au moment où la souveraineté numérique européenne s’invite au coeur des débats… Un objectif de chiffre d’affaires inédit pour une start-up européenne Mistral AI […]