Speedball revient sur PS5, Xbox Series et PC : Rebellion relance le sport futuriste

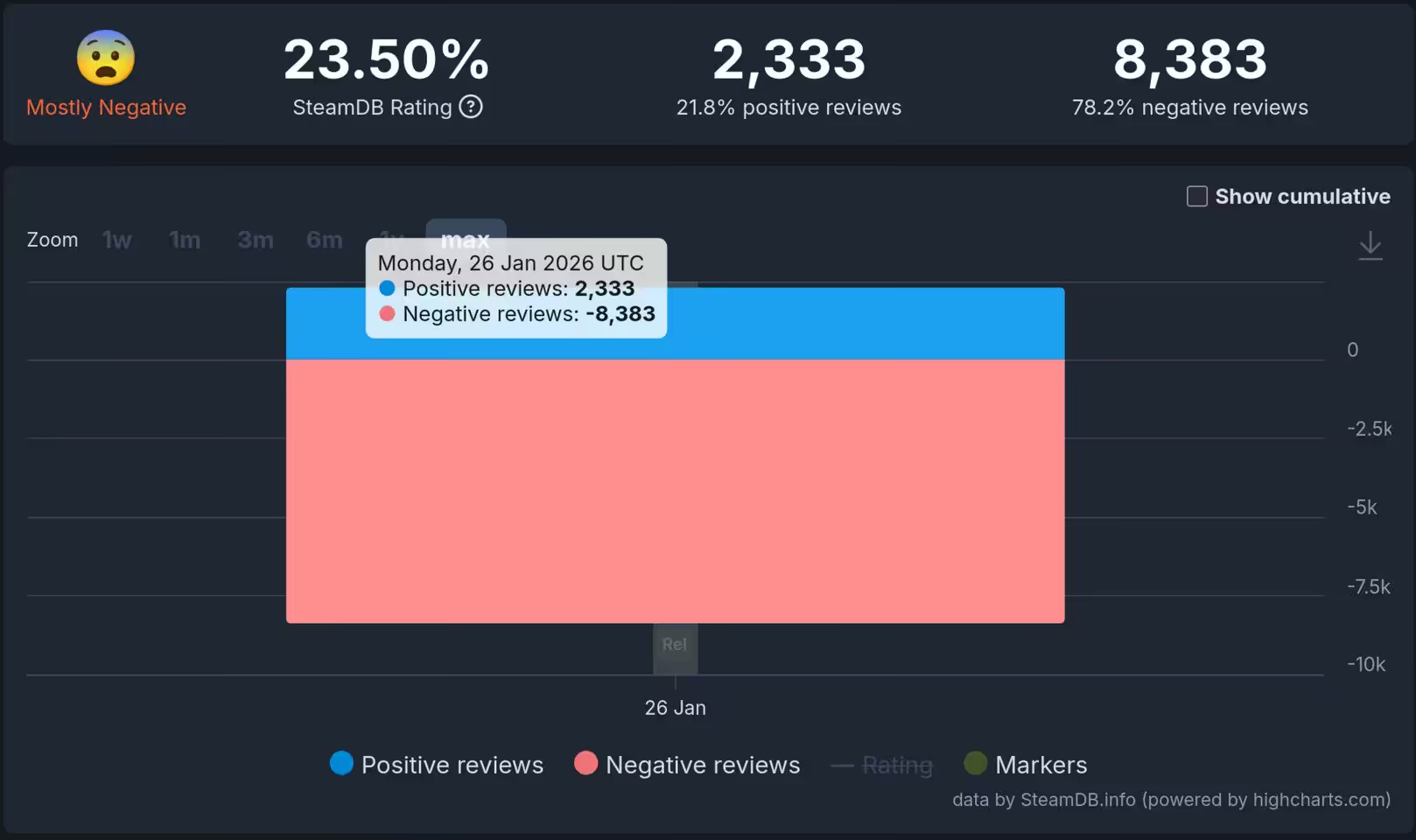

Après plus d’un an d’Early Access lancé en octobre 2024, ce pilier du cyberpunk sort enfin de l’ombre et revient avec une ambition claire : frapper fort, sans détour. Violence assumée, rythme brutal, et un lancement sur PS5, Xbox Series X|S et PC, le tout à un prix d’appel volontairement contenu.

Speedball s’offre une renaissance moderne

Rebellion, studio derrière Sniper Elite, Atomfall et Zombie Army, relance Speedball, licence culte des Bitmap Brothers (1988). La version complète est disponible en numérique sur Xbox Series X|S et PlayStation 5, et sur PC via Steam à 29,99 €.

Le décor plante 2138 et ses mégacorpos qui abrutissent les foules à coups de sport gladiateur. Sur le terrain, l’essentiel tient en trois mots: vitesse, collision, opportunisme.

Modes, arènes et rythme de jeu

Le League Mode aligne 10 équipes pour une saison complète et un titre de champion. Les rencontres sont rapides, explosives et volontairement imprévisibles, portées par des passes à haute vitesse, des tirs cadrés et des combos d’équipe.

Les arènes se déclinent en variantes Brutal et Standard, avec obstacles et capacités spécifiques pour renverser un match. La Slam Cam en ralenti capture les plaquages les plus sales, histoire d’appuyer là où ça fait mal.

L’ossature mêle match arcade et micro-gestion: constituez un effectif adapté à votre style grâce aux traits et talents individuels, entraînez-vous contre l’IA, puis basculez en ligne ou en local.

Un retour attendu pour les amateurs de futurisme rugueux

Le trailer de lancement est disponible sur YouTube, et Rebellion accompagne la sortie avec une collection de vêtements, accessoires et homeware sur sa boutique. Prix identique sur consoles et PC: 29,99 $ environ.

Replonger Speedball dans un cadre 4K/60 et un écosystème multi-plateformes consolide une niche laissée vacante entre sport arcade et brawler. Si le matchmaking tient la charge et que le League Mode offre du méta-jeu, la proposition peut fédérer une scène durable, au-delà du simple coup de nostalgie.

Source : TechPowerUp