Permis de conduire : le FSD de Tesla est déjà trop « humain » pour l'avoir

Depuis quelque temps, Tesla multiplie les opérations de séduction pour promouvoir son système de conduite autonome, le Full Self-Driving (FSD), sur le Vieux Continent. Multipliant les prises en main auprès des journalistes et des influenceurs, la firme d'Austin tente de faire pression sur les régulateurs européens. Elon Musk, fidèle à lui-même, a promis à plusieurs reprises que le précieux sésame serait accordé dès ce mois de février en Chine et en Europe. Tic-tac : il ne reste plus que quelques jours au milliardaire pour tenir son pari.

Dans ce contexte, la chaîne YouTube La Chaine EV a eu une idée particulièrement pertinente : soumettre le FSD à l'épreuve ultime du candidat conducteur. Si l’IA de Tesla passait le permis de conduire, finirait-elle avec le papier rose (ou plutôt la carte sécurisée) en poche ?

Pour le savoir, l’équipe a organisé un test grandeur nature à Saint-Priest. Un choix loin d'être anodin, puisque ces routes ont fait transpirer des générations de Lyonnaises et de Lyonnais lors de l'examen. Pour valider l'expérience, ils se sont adjoints les services de Sébastien, enseignant de la conduite, prêt à noter la machine comme n'importe quel élève.

Recalée, mais avec les honneurs

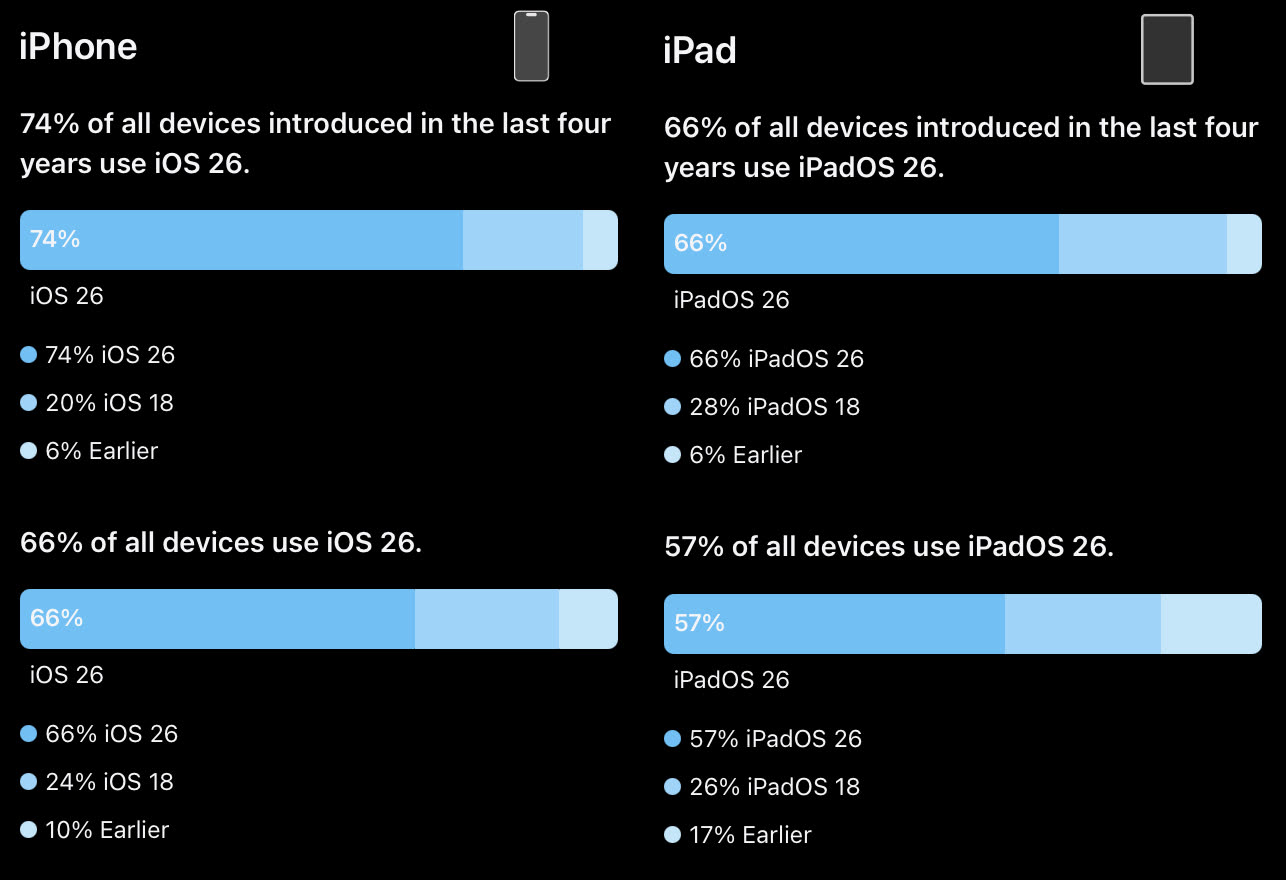

Alors, la voiture d’Elon Musk est-elle repartie avec la mention "Reçu" ? La réponse est non, mais le tableau est plus nuancé qu’il n'y paraît. Techniquement, le FSD a obtenu la note de 20,5 sur 31, un score qui, en théorie, permet de décrocher l'examen. Le problème, c'est que la Tesla a cumulé deux erreurs éliminatoires qui ne pardonnent pas devant un inspecteur.

La première faute concerne un manque de courtoisie ou plutôt un excès de zèle : la Tesla a tenté de s'insérer dans un rond-point de manière autoritaire, frôlant le refus de priorité. La seconde erreur est un grand classique des échecs au permis : la voiture a terminé sa course sur une voie réservée aux bus. Un manque de lecture de la signalisation au sol qui, dans le monde réel, met fin prématurément à l'épreuve.

Un conducteur « trop humain » ?

Le plus riche en enseignements reste toutefois le « caractère » affiché par le système. Paradoxalement, ce n’est pas un manque de maîtrise technique qui a pénalisé le FSD, mais son mimétisme du comportement humain.

L'instructeur souligne un point fascinant : le logiciel ne se comporte pas comme un élève appliqué respectant scrupuleusement le Code de la route à la lettre. Il agit plutôt comme un conducteur expérimenté qui aurait accumulé des tics de conduite et quelques mauvaises habitudes au fil des années. Un paradoxe pour une intelligence artificielle, qui semble déjà avoir appris à s'affranchir de la rigueur scolaire pour privilégier une conduite plus fluide, mais parfois hors des clous législatifs.