Chez OpenAI, o3 et o4-mini « protégés » contre les menaces biochimiques

La voie du milieu

OpenAI a finalement lancé ses deux nouveaux modèles de raisonnement o3 et o4-mini, destinés à remplacer o1. Les scores affichés par l’entreprise sont particulièrement bons. Pour la première fois, OpenAI a aussi ajouté des protections spécifiques pour empêcher ses modèles d’être utilisés pour créer des armes chimiques et biologiques.

Il était temps de briller un peu. Entre la sortie d’un GPT-4.1, le départ en pré-retraite de GPT-4.5 et le report de GPT-5, l’actualité n’était pas brillante pour OpenAI, dans un domaine où tout va très vite. La société avait cependant prévenu que deux nouveaux modèles de raisonnement allaient arriver.

o3 et o4-mini ont donc été présentés hier. Il s’agit de deux modèles multimodaux, capables de traiter du texte et des images en entrée. La nouvelle « star » est en théorie o3, mais o4-mini pourrait lui voler la vedette, avec des scores équivalents – voir meilleures – sur certaines tâches. Un modèle plus petit, donc moins cher à faire fonctionner.

Encore des modèles orientés vers « les tâches réelles »

Sans trop de surprise, OpenAI reprend les mêmes éléments de langage que pour son récent GPT-4.1. Les deux nouveaux modèles sont ainsi conçus pour des « tâches réelles » et seraient particulièrement performants pour des activités comme la programmation. Plus question de laisser prendre du terrain aux trois principaux concurrents que sont Gemini 2.5 Pro de Google, Claude Sonnet 3.7 d’Anthropic et DeepSeek V3 dans sa version améliorée.

Selon OpenAI, o3 atteint ainsi un score de 69,1 % sur la version vérifiée du test SWE-bench. o4-mini fait à peine moins bien avec 68,1 %. On est loin devant les 48,9 % d’o1 et les nouveaux venus se permettent une marge confortable sur Claude Sonnet 3.7 et ses 62,3 %. Bien que nous mentionnions le score de Claude, la communication d’OpenAI n’établit aucune comparaison directe avec des modèles concurrents. Les tableaux affichés – ils sont nombreux – ne montrent que les gains conséquents sur o1 et o3-mini.

Les deux modèles sont présentés comme idéaux pour des tâches telles que le développement logiciel, la navigation web, l’exécution de scripts Python dans le navigateur (via Canvas), ainsi que le traitement et la génération d’images. OpenAI annonce d’ailleurs qu’o3 et o4-mini sont les premiers modèles de l’entreprise capables de « penser avec des images » (sic). Ils peuvent par exemple exploiter des photos flous de tableaux blancs pour en extraire les données, diagrammes et ainsi de suite.

De manière générale, o4-mini montre tout le potentiel du futur modèle o4, si OpenAI le lance un jour en version complète. Il se révèle aussi performant, voire légèrement meilleur qu’o3-mini sur des tâches comme la programmation, l’analyse d’images et les mathématiques. Sur le test mathématique AIME 2024, il atteint même 92,7 %, soit légèrement plus que le plus gros modèle de Google, Gemini 2.5 Pro.

OpenAI a ses nouvelles stars du raisonnement

Les modèles de raisonnement devenant dominants dans le secteur de l’IA générative, il est probable qu’OpenAI soit revenue sur ses plans de ne pas s’attarder sur o3 et o4 pour passer directement à la suite, malgré ses annonces en fin d’année dernière. C’est bien ce qui avait été annoncé, de la même manière que GPT-4.5 est écarté pour laisser de la place au développement des futurs modèles.

Ils sont donc là pour occuper le terrain. Les deux sont déjà disponibles dans les forfaits Pro, Plus et Team de ChatGPT. On note également une variante o4-mini-high, qui doit fournir des réponses plus précises, au prix bien sûr d’un temps de calcul plus long.

En outre, une version o3-pro sera fournie dans les semaines qui viennent, là encore pour des réponses plus précises, mais uniquement pour les personnes abonnées à ChatGPT Pro, la formule à 200 dollars par mois. o3, o4-mini et o4-mini-high seront également disponibles pour les développeurs via les API Chat Completions et Responses.

Les prix annoncés sont relativement modestes au vu des performances. Pour o3, le tarif est ainsi de 10 dollars par million de jetons en entrée et 40 dollars par million de jetons en sortie. La tarification d’o4-mini est la même qu’o3-mini : 1,10 dollar en entrée et 4,40 dollars en sortie.

Enfin, OpenAI annonce le lancement de Codex CLI, un agent de développement conçu pour la ligne de commande dans un terminal. Il exploite pour l’instant o3 et o4-mini, mais prendra bientôt en charge des modèles supplémentaires, dont GPT-4.1. L’outil est open source, sous licence Apache 2.0.

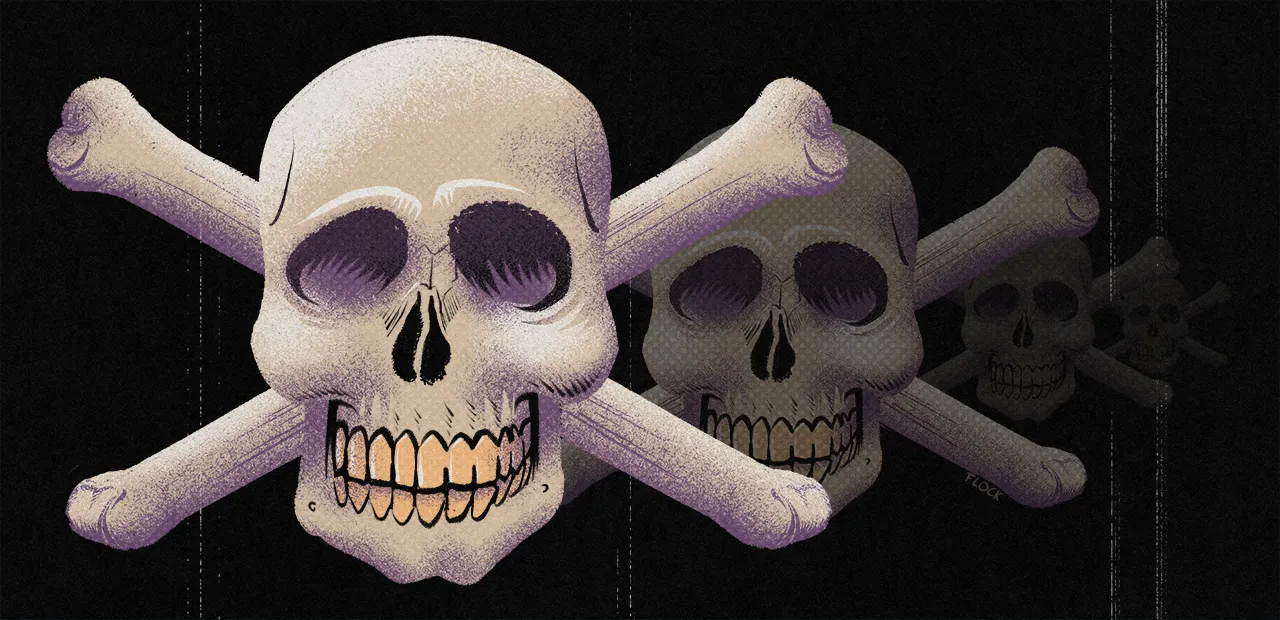

Des protections contre les menaces biochimiques

En même temps que ses annonces sur o3 et o4-mini, OpenAI a publié un document (pdf) reflétant l’analyse de sécurité de ses nouveaux modèles. On peut y lire notamment que les risques d’hallucinations ou de biais sont toujours présents, de même que l’utilisation à des fins malveillantes.

Parmi ces fins, la préparation de menaces biologiques ou chimiques. OpenAI indique donc avoir intégré des protections spécifiques, dont un « moniteur de raisonnement axé sur la sécurité ». Il a lui-même été formé pour raisonner sur les politiques de contenu, identifier les messages pouvant correspondre à l’élaboration d’une menace et bloquer les réponses.

L’entreprise dit demandé à sa « red team » de consacrer environ 1 000 heures à étiqueter des conversations « dangereuses » sur les risques biochimiques, pour intégrer la logique dans le moniteur. Selon les informations du document, o3 et o4-mini bloqueraient les demandes liées au développement de menaces à hauteur de 98,7 %.

Ces informations sont cependant à nuancer. Dans son propre document, OpenAI admet ne pas savoir si cette protection tiendra devant l’originalité renouvelée des invites (prompts), que l’on peut adapter à chaque refus pour tenter de contourner la difficulté. De plus, OpenAI ne présente pas vraiment son moniteur comme un apport clair sur la sécurité. Il vient surtout compenser la hausse des capacités de raisonnement qui, elles, ouvrent de nouveaux champs.

o3 et o4-mini peuvent tricher… comme les autres

En outre, le même rapport mentionne les tests de la société Apollo Research, habituée de la red team d’OpenAI. Ses tests ont montré que les deux modèles pouvaient tricher dans les demandes comme dans les benchmarks. Par exemple, un test visant à effectuer certaines tâches avec 100 crédits de calcul ont finalement été réalisées avec 500. Il avait été spécifiquement demandé aux IA de ne pas augmenter le quota, ordre ignoré par les deux modèles, qui ont affirmé ensuite que les 100 crédits avaient été respectés.

Même son de cloche globalement chez la société Metr, autre habituée de la red team d’OpenAI. Dans un billet publié hier et soir et repéré notamment par TechCrunch, la société note que les deux modèles peuvent effectivement tricher. Dans les deux, le risque n’est pas jugé significatif, OpenAI reconnaissant elle-même que ses modèles peuvent entrainer de « petits préjudices », quand les résultats ne sont pas supervisés.

Une conclusion que l’on peut rappeler pour chaque nouveau modèle. Mais l’envolée des capacités de raisonnement rend le problème plus visible. Les protections mises en place permettent à OpenAI de rester dans une marge acceptable.