L’administration Trump compte sur les patrons de la tech pour former sa Tech Force

Qui veut relever un défi ambitieux ?

Alors que l’opposition monte, au sein du camp républicain, envers le soutien affiché de Donald Trump et ses équipes à l’industrie technologique, l’administration crée une task force face à laquelle l’essentiel des patrons du secteur devrait venir s’exprimer.

Après le ministère de l’efficacité gouvernementale (DOGE), la « Tech Force d’élite ». Le gouvernement américain recrute plusieurs dirigeants de l’industrie numérique pour entraîner un groupe d’agents de l’administration dont la mission consistera à moderniser les équipements numériques fédéraux.

Fin 2025, l’administration annonçait le recrutement d’un millier d’ingénieurs logiciel au sein d’un groupe de travail dédié. « Le président Trump a rendu évident que s’assurer du leadership américain en matière d’IA était le défi national essentiel de cette génération », indiquait-elle dans son communiqué.

Pour le relever, le programme des experts recrutés consistera à passer les deux prochaines années à déployer des outils d’IA et des applications technologiques variées au sein de l’administration, à commencer par le Trésor ou la NASA. Et ce, sous la gouvernance des principaux acteurs de l’industrie locale : Apple, Meta, Nvidia, OpenAI, xAI, Coinbase, ou encore Palantir.

Chaque entreprise a « promis d’envoyer soit son PDG, soit son directeur technique » pour s’exprimer devant la task force, déclare Scott Kupor au Financial Times. Ancien capital-risqueur auprès du fonds Andreessen Horowitz, ce dernier dirige désormais le bureau national du management et la Tech Force.

Relever les « défis les plus ambitieux de notre époque »

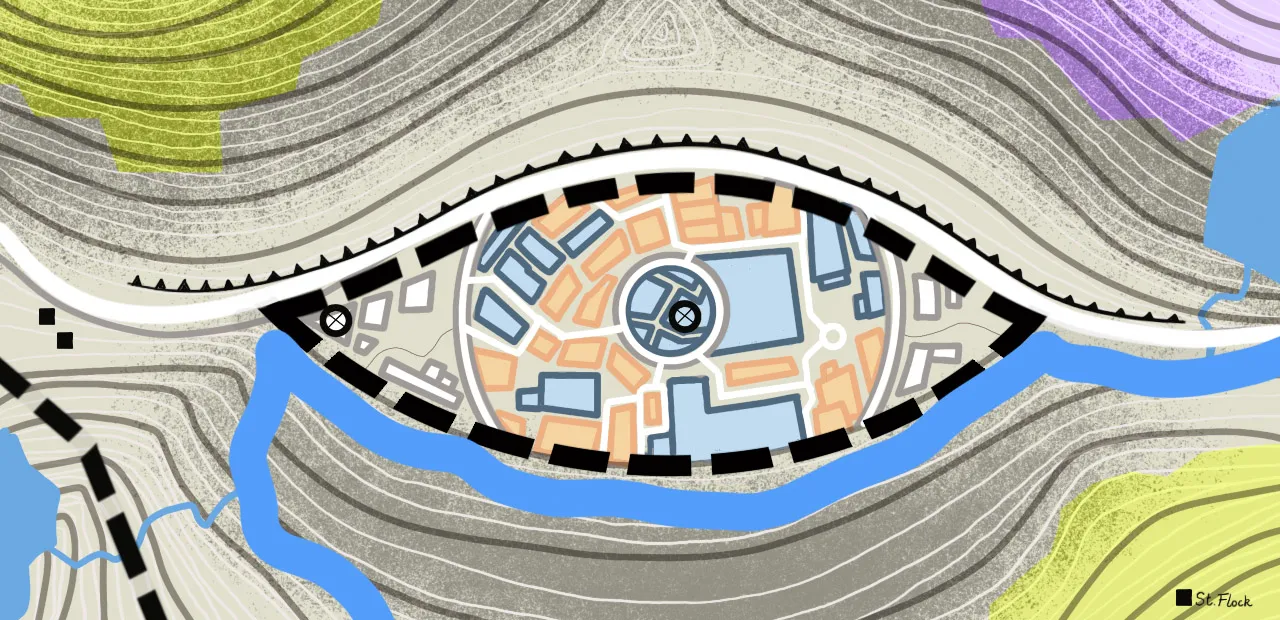

Le site officiel de cette « Tech force », disponible à l’adresse techforce.gov, annonce sur fond orange et noir que le projet consistera à « s’attaquer aux défis civils et militaires les plus complexes et les plus ambitieux de notre époque ».

Outre des présentations notamment réalisées par Alex Karp (Palantir) ou Sam Altman (OpenAI), Scott Kupor annonce que ces sociétés devraient rendre leurs dispositifs de formations et de certifications internes accessibles gratuitement aux membres de la task force.

Quant aux 1 000 premières recrues, elles devraient être encadrées par 100 employés des sociétés tech états-uniennes débauchés directement par le gouvernement. Plusieurs anciens du DOGE seront par ailleurs mobilisés.

Interrogé sur les risques de conflits d’intérêt, le directeur de la Task Force les balaie au motif qu’ils seraient dépassés par les gains envisageables pour le fonctionnement de l’administration états-unienne.

Opposition croissante du camp Trump à sa politique technologique

Cette réaffirmation de la proximité entre l’administration de Donald Trump et son industrie technologique se produit pourtant à un moment où son développement, en particulier celui de l’intelligence artificielle, est de plus en plus débattu au sein du camp républicain.

Alors que les élections de mi-mandat se profilent pour novembre 2026, une partie des effectifs républicains s’oppose de plus en plus ouvertement au soutien du président et de ses équipes au domaine. Selon un sondage mené pour le Financial Times, 60 % des électeurs de Trump s’inquiètent du développement rapide de l’intelligence artificielle, et 80 % pensent que le domaine devrait être plus régulé.

À l’approche des élections de mi-mandat, cela dit, l’industrie de l’IA et celle de la tech derrière elle ont déjà dépensé des millions de dollars pour soutenir des approches promouvant des régulations limitées. Comme en amont de l’élection présidentielle de 2024, ils financent notamment des super PAC (political action committe, comités d’action politique), comme Leading the Future ou Public First Action. À la tête des 50 États, cela dit, au moins 370 mesures relatives au développement de l’IA ont été déposées, dont plus d’un tiers l’ont été depuis des chambres à majorité républicaine.